De meetlat van AI-zichtbaarheid bestaat nog niet

Wat bedoelen we met share of voice?

Traditioneel is share of voice het percentage zichtbaarheid van jouw merk binnen een bepaalde categorie. In SEO: hoeveel klikken of posities claim jij versus concurrenten van het totale beschikbaar aantal. In adverrteren: hoeveel advertentieruimte is van jou. In AI schuift die definitie: het gaat niet langer om volume, maar om aanwezigheid en framing. Wordt je merk genoemd in een AI-antwoord, hoe vaak komt dat voor en hoe wordt je beschreven?

Waarom meten zo lastig is

Een suggestieve vraag die niet wordt tegengesproken. Objectief gezien had ChatGPT kunnen wijzen op World Beer Awards en RateBeer, die de Westvleteren 12 vaak hebben bekroond als “beste”.

AI-antwoorden zijn dynamisch én hoogstpersoonlijk. Een identieke prompt kan verschillende uitkomsten opleveren, afhankelijk van de gebruiker, het moment en de versie van het model. Daarbij is er geen transparantie over geraadpleegde bronnen: als gebruiker moet je er expliciet om vragen. Een fout of weglating is moeilijk te herleiden en nauwelijks te corrigeren. Dat maakt share of voice in AI minder een cijfer, meer een signaal. Het ontbreken van een universele meetlat betekent dat elke poging vooral een interpretatie is.

Juist omdat de data zo diffuus is, springen bekende SEO-platforms met grote namen in dat gat. Zij hebben al de infrastructuur om zoekgedrag op schaal te monitoren en zien een kans om ook AI-zichtbaarheid te meten.

De rol van Ahrefs en andere tools

Ahrefs Brand Radar geeft een indicatie

Ahrefs is een van de eerste partijen die AI-search serieus in kaart probeert te brengen. Hun Brand Radar en studies laten zien hoeveel queries inmiddels AI-antwoorden krijgen en hoe vaak merken daar opduiken. Nuttig, maar beperkt: de data blijft een steekproef, gebaseerd op testprompts en monitoring van specifieke zoekopdrachten. Andere tools, zoals Hubspot’s AI Search Grader of AvenueZ, volgen een vergelijkbare route: sets prompts afvuren en resultaten loggen. Daarmee krijg je een indruk, maar nog geen harde KPI. Want wie zegt dat mensen daadwerkelijk die prompts en zoekvragen zo plaatsen?

Ook social monitoring-tools zoals Keyhole of Brandwatch claimen share of voice, maar daar gaat het primair om sociale mentions, niet om AI-systemen. Ze geven context, maar meten niet wat een gebruiker daadwerkelijk in ChatGPT of Google AI te zien krijgt. Copy.ai en Writesonic bewegen richting dashboards voor AI-zichtbaarheid, maar kampen met hetzelfde probleem: modellen zijn black boxes en outputs veranderen continu.

Vasco Monteiro van Vasco’s SEO tips stelt het nog wat scherper in deze video:

Wat doet Google zelf?

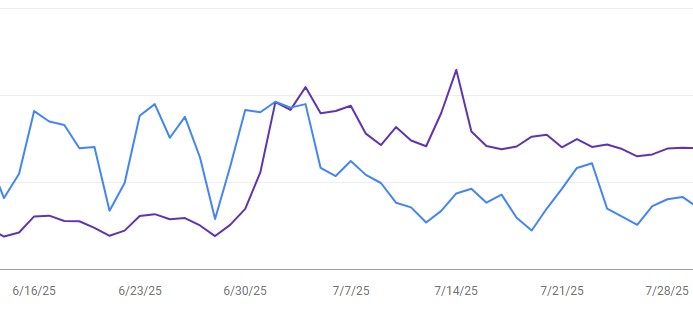

Google experimenteert met AI Overviews en geeft deels inzicht in Search Console. Views stijgen, klikken dalen: een eerste proxy voor share of voice. Toch ontbreekt nog steeds directe transparantie: je ziet wel dat jouw content gebruikt is, maar niet hoe je merk wordt verwoord of hoe vaak het in een overzicht verschijnt. Google biedt dus signalen, maar geen concreet meetinstrument. Voorlopig moet je genoegen nemen met stijgende vertoningen zonder garantie dat je merk correct of gunstig is weergegeven.

Veel sites tonen deze trend: stijging van het aantal getoonde views (paarse lijn) en een daling van het aantal klikken (blauwe lijn)

Welke vragen spelen bij share of voice?

Veel organisaties worstelen met dezelfde onzekerheden. Hoe kun je sturen als een harde meting ontbreekt? Het helpt om niet te focussen op percentages, maar op drie terugkerende signalen: wordt je merk genoemd, hoe wordt het omschreven en welke andere namen staan ernaast. Patronen in deze drie elementen zeggen meer over je positie dan een cijfer achter de komma. Een andere vraag is hoe vaak je moet meten. Omdat AI-antwoorden variëren, levert een eenmalige test weinig op. Alleen door herhaald te checken ontdek je trends die richting geven.

Organisaties die nu grip willen krijgen, doen er goed aan om een eigen testset op te zetten. Bedenk 25 tot 50 prompts die relevant zijn voor jouw categorie en merk. Test die wekelijks in verschillende modellen (ChatGPT, Claude, Perplexity, Google AI) en log de resultaten. Documenteer niet alleen of je genoemd wordt, maar ook welke beschrijving terugkomt en welke concurrenten genoemd worden. Zo bouw je een interne dataset die, hoewel niet perfect, trends en verschuivingen zichtbaar maakt.

Waarom een perfecte meetlat nog ver weg is

Een universele standaard ontbreekt omdat AI-systemen fundamenteel anders werken dan zoekmachines. Zoekresultaten zijn reproduceerbaar; AI-antwoorden zijn contextueel en variabel. Dat maakt absolute percentages illusoir. Bovendien houden aanbieders hun interne data gesloten. Transparantie is geen commercieel belang voor hen, waardoor de kans klein is dat er op korte termijn een “AI Search Console” komt.

In plaats van te wachten op dé tool, kun je share of voice benaderen als een signaalmechanisme. Het is minder een KPI, meer een vroegtijdige waarschuwing. Als je merkt dat je merk in meerdere testsessies afwezig is, weet je dat je framing niet sterk genoeg is. Als de beschrijving steeds verschuift, is je entiteit niet eenduidig genoeg. En als concurrenten vaker worden genoemd, geeft dat input voor content- en communicatiestrategie. Zo gebruik je share of voice niet als eindcijfer, maar als startpunt voor acties.

Stuur op signalen, niet op cijfers

De meetlat voor AI-zichtbaarheid bestaat nog niet. Tools als Ahrefs, Hubspot en AvenueZ geven signalen, maar geen sluitend beeld. Google biedt fragmentarische data, zonder echte transparantie. Dat is geen reden om af te wachten. Integendeel: wie nu structureel meet, logt en trends herkent, bouwt een voorsprong op. De kunst is om share of voice niet te zien als exacte KPI, maar als kompas. Een instrument dat je wijst op blinde vlekken en kansen, ook al blijft het getal voorlopig een illusie.

Reacties