Snel je content indexeren: de stille motor achter SEO én GEO

Indexatie is het nulpunt van online zichtbaarheid. Zonder indexatie bestaat een pagina voor zoekmachines niet, en blijft organisch verkeer uit. Minder zichtbaarheid betekent minder bereik en voor de meeste organisaties dus ook minder business. Hetzelfde geldt voor GEO: AI-antwoorden en chat-interfaces citeren vooral wat ze kunnen vinden, begrijpen en vertrouwen. Dus hoe werkt indexeren precies en wat kun je doen om jouw content (sneller) te indexeren?

Dit artikel legt helder uit hoe indexatie werkt, hoe je problemen voorkomt en oplost, hoe je Google Search Console inzet als cockpit, en hoe je met tooling en distributie discovery versnelt. Tot slot vind je best practices om de hele keten duurzaam te verbeteren.

De crux om te onthouden als je dit leest als marketeer: vroeger was indexeren misschien een technisch ding in je organisatie, vandaag is indexeren de basis voor je SEO succes. En dus jouw succes als je SEO inzet.

Waarom indexatie ertoe doet

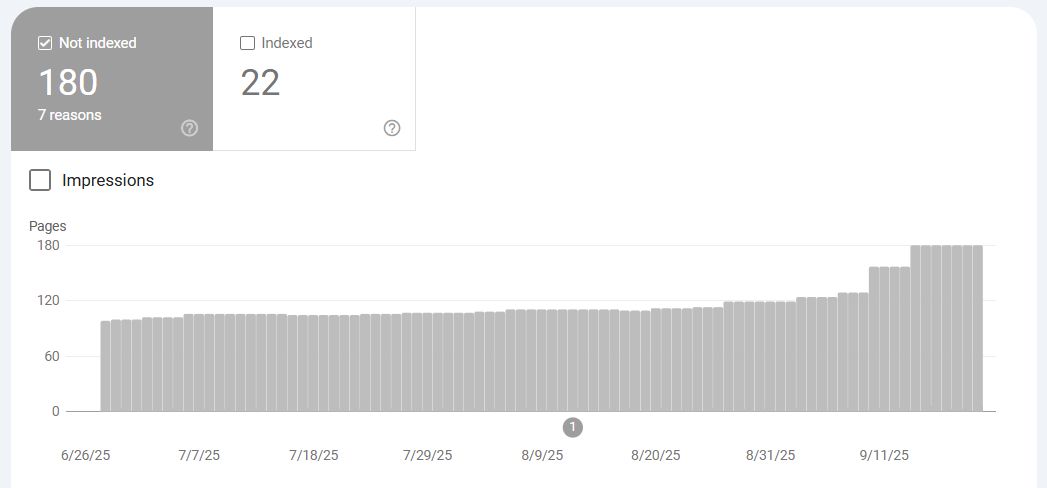

De meeste pagina’s van deze site zijn niet geïndexeerd door Google en worden dus ook niet als zoekresultaat getoond

Indexatie verbindt maken en gevonden worden. Een nieuwe pagina die niet wordt ontdekt, gecrawld en geïndexeerd, kan niet ranken en zal niet in AI-antwoorden opduiken. Snelle indexatie verkort de tijd tussen publicatie en eerste vertoningen, en vergroot de kans dat jouw informatie wordt meegenomen als betrouwbare bron. In een tijd waarin gebruikers minder klikken en vaker antwoorden verwachten, kan de snelheid en kwaliteit van indexatie het verschil maken tussen meedoen of verdwijnen.

Het goede nieuws: Google heeft een bijzonder handige tool waarmee je het hele proces kunt beïnvloeden: Google Search Console. Maar eerst is het belangrijk om te snappen welke stappen er vooraf gaan aan het getoond worden in Google.

Van discovery tot indexering: hoe het proces werkt

Indexatie is geen zwarte doos. Het volgt een logische keten waarin elk onderdeel een hefboom is voor de volgende stappen:

- Discovery: zoekmachines leren nieuwe url’s kennen via interne links, externe links, sitemaps, RSS, nieuwsfeeds, social posts en partnermentions. Hoe meer betrouwbare ingangen naar jouw nieuwe pagina’s, hoe groter de kans op snelle ontdekking.

- Crawling: de crawler haalt HTML en bronnen op. Sitestructuur, interne links, statuscodes en performance bepalen hoe makkelijk en vaak dit gebeurt. Trage of instabiele servers remmen crawlen af.

- Rendering: als inhoud pas na JavaScript zichtbaar wordt, moet de bot renderen. Dat kost tijd en budget. Kritieke content die direct in de HTML staat, wordt sneller en consistenter verwerkt.

- Indexering: de motor beoordeelt of een pagina in de index thuishoort. Canonical-keuze, duplicatie, kwaliteit, consistentie en technische signalen spelen mee. Pas daarna kan de pagina ranken of als bron in AI-antwoorden verschijnen.

- Crawlbudget: elk domein krijgt feitelijk een plafond aan crawlactiviteit, afhankelijk van vertrouwen, performance en omvang. Grote sites en snel groeiende sites merken dit het meest. Efficiënte architectuur en een schone technische basis zorgen dat het budget naar de juiste pagina’s gaat.

Deze video van Google zelf legt het hele proces stapsgewijs uit:

Je stuurknoppen: robots.txt, sitemap.xml en llms.txt

Met deze drie bekende, en één nieuwere, instrumenten stuur je discovery en crawling op hoofdlijnen.

- robots.txt: gebruik het om onbelangrijke paden uit te sluiten en kruipen te focussen, maar blokkeer geen content die je in de index wilt. Onthoud het verschil tussen crawl-blokkade en index-signalen. Test wijzigingen voordat je ze live zet.

- sitemap.xml: houd je sitemap actueel en uitsluitend met canonieke url’s. Splits grote sitemaps op, valideer regelmatig en verwijder 404’s en noindex-url’s. Laat nieuwe content snel in de sitemap verschijnen, bij voorkeur automatisch.

- llms.txt: dit document wordt gebruikt als gecureerde verwijzer naar je beste inhoud voor modellen. Positioneer het als aanvullend, niet als vervanging. Het kan discovery door AI-systemen vergemakkelijken, maar klassieke SEO-signalen blijven leidend voor zoekmachines.

Test direct of jouw site deze bestanden heeft. Ga naar je eigen URL, zoals in mijn geval Bloeise.nl en bekijk de bestanden:

- Https://bloeise.nl/robots.txt

- https://bloeise.nl/sitemap.xml (Linkt door naar https://bloeise.nl/sitemap_index.xml)

- https://bloeise.nl/llms.txt

Deze bestanden zijn voor iedereen toegankelijk. En ja, je kunt dus ook zo kijken hoe je concurrenten of grote merken dit aanpakken.

Google search console als cockpit

Op YouTube vind je tig video’s van zelfuitgeroepen Guru’s (te herkennen aan die stomme flashy thumbnails) maar het best startpunt voor GSC is Google zelf. Google Search Central heet het officiële Google account op YouTube over Google Search, en ze leggen in deze training over meerdere video’s de exacte werking uit:

Google Search Console (GSC) is je controlepaneel om discovery, crawling en indexatie te begrijpen en te sturen.

- Indexeringsrapporten: lees de statussen nauwkeurig. “Gedetecteerd, momenteel niet geïndexeerd” wijst op discovery zonder opname. “Gecrawld, momenteel niet geïndexeerd” suggereert kwaliteits- of duplicatievragen. “Uitgesloten door ‘noindex’” is een expliciet signaal dat je zelf gaf. Elk label vraagt een eigen remedie.

- URL-inspectie: voer een live test uit om te zien wat Google nu van de pagina ziet. Controleer “Opgenomen in Google?”, de gerenderde HTML en “Gedetecteerd via” om te begrijpen hoe Google de url vond (sitemap, verwijzende pagina, enzovoort).

- Sitemaps: dien sitemaps in, monitor fouten en vergelijk het aantal items met het aantal geïndexeerde url’s. Bij grote verschillen is er vaak een structureel probleem in kwaliteit, duplicatie of toegankelijkheid.

- Crawlstatistieken: analyseer hits, responsecodes, gemiddelde response-tijd en host load. Schommelingen na deploys of migraties kunnen indexatie remmen. Koppel deze data aan wijzigingen in code, caching of infrastructuur.

- robots-check: controleer of prioritaire paden niet per ongeluk geblokkeerd zijn. Een kleine disallow-regel kan grote gevolgen hebben.

Veelvoorkomende indexatieproblemen en hoe je ze oplost

De meeste indexatieproblemen vallen in een aantal bekende categorieën. De grootste 2 zijn:

Discovered, currently not indexed

Betekenis: Google kent de URL wel, maar heeft de pagina (nog) niet gecrawld of gekozen voor opname. Dit duidt meestal op onvoldoende prioriteit, zwakke signalen of een belemmering in discovery of kwaliteit. Het is vaak een tijdelijk stadium, maar kan hardnekkig worden als onderliggende oorzaken blijven bestaan.

- Typische oorzaken

- Zwakke discovery-signalen: weinig of geen interne links, geen vermeldingen extern, url staat wel in de sitemap maar is verder “wees”.

- Lage verwachte waarde: dunne of overlappende content, bijna-duplicaten, veel vergelijkbare pagina’s met minimale verschillen.

- Crawlbudget en prioritering: grote sites, veel nieuwe url’s tegelijk, of lage domeinbetrouwbaarheid en performance, waardoor discovery niet meteen tot crawl leidt.

- Sitemap-ruis: sitemaps met 404’s, noindex-url’s, parametrische varianten of niet-canonicals verminderen vertrouwen in de feed.

- Architectuur: pagina’s te diep in de hiërarchie, geen contextuele links vanaf hubs of recente artikelen.

- Diagnose in GSC en daarbuiten

- URL-inspectie: controleer “Opgenomen in Google?”, “Gedetecteerd via” (sitemap, verwijzende pagina), en de gerenderde HTML.

- Indexeringsrapporten: volg de aantallen “Gedetecteerd, momenteel niet geïndexeerd” per dag of week. Schommelingen na deploys of contentdrips wijzen op prioritering.

- Crawlstatistieken: check host load, responsecodes en gemiddelde responstijd. Een hoge TTFB of spikes in 5xx remmen crawlbereidheid.

- Logs en analytics: zie of bots de url wel eens proberen. Geen botverkeer op deze url’s versterkt het discovery-probleem.

- Actieplan: snelle winst

- Interne links: voeg 2–5 contextuele links toe vanaf relevante hub- en pillarpagina’s, en plaats de url in een recente blog of overzichtspagina. (Tip: WordPress plugin Internal link juicer!)

- Sitemap schoonmaken: alleen canonicals, geen 404/noindex/duplicaten. Herbouw en ping de sitemap direct bij publicatie. (En in Yoast SEO alle feeds uitzetten!)

- Content versterken: voeg intentie-gedreven alinea’s, entiteiten en mini-FAQ’s toe. Combineer overlappende pagina’s tot één sterker stuk.

- Prestatie verbeteren: verlaag TTFB, optimaliseer caching en stabiliseer hosting. Snellere respons verhoogt crawlfrequentie en vertrouwen.

- Externe ingang: verspreid via RSS en social. Partnermentions of relevante communityposts kunnen discovery versnellen.

- Structurele preventie

- Publicatieritueel: interne links, sitemap-update, RSS en social op het moment van livegang.

- Architectuur: zorg dat nieuwe pagina’s maximaal drie klikken van een hub liggen.

- Template-hygiëne: voorkom parametrische varianten en dunne templating zonder unieke elementen.

- Monitoring: alert op stijging van dit label in GSC en koppel het aan releases of contentbatches.

Crawled, currently not indexed

Betekenis: Google heeft de pagina wel bezocht en gerenderd, maar kiest ervoor deze (nog) niet in de index op te nemen. Dit wijst vaker op inhoudelijke of canonieke redenen dan op pure discovery. De crawler heeft tijd en budget besteed, maar vindt de pagina niet waardig of niet uniek genoeg voor opname.

- Typische oorzaken

- Kwaliteitssignalen onvoldoende: dunne content, herhaling van bestaande stukken, soft 404 (subjectieve “bijna leeg”).

- Duplicatie en canonical: meerdere varianten, onduidelijke canonical, verkeerde self-referential canonical of conflict met hreflang.

- Render-issues: de zichtbare hoofdcontent staat achter JavaScript, waardoor de bot bij render weinig of niets substantieels aantreft.

- Mismatch intentie: content sluit niet aan op een duidelijke zoekintentie of overlapt te veel met bestaande pagina’s op je site.

- Over-optimalisatie of ruis: te veel vergelijkbare pagina’s tegelijk gepubliceerd, tag-archieven zonder meerwaarde, filter- en sorteervarianten.

- Diagnose in GSC en daarbiten

- URL-inspectie (live test): bekijk de gerenderde HTML. Staat de hoofdcontent echt in de DOM zonder interactie of uitgestelde scripts.

- Coverage-details: bevestig het exacte label. Bij “Gecrawld, momenteel niet geïndexeerd” zie je vaak patronen per template.

- Vergelijkbare pagina’s: zet de url naast goed geïndexeerde siblings. Wat ontbreekt aan diepte, media, entiteiten, interne links.

- Logfiles: controleer of Google periodiek terugkomt. Herhaalde crawls zonder opname wijzen op kwalitatief of canoniek probleem.

- Actieplan: snelle winst

- Content verdiepen: voeg originele voorbeelden, data, definities en mini-FAQ’s toe. Maak de pagina duidelijk beter dan de dichtstbijzijnde sibling.

- Canonical en duplicatie: kies één canonical, verwijder overbodige varianten, normaliseer parameters en link intern uitsluitend naar de canonical.

- Renderbare hoofdcontent: breng de kerntekst en belangrijke koppen server-side in de HTML. Reduceer afhankelijkheid van client-side rendering.

- Interne linking: geef de pagina een prominente plek in relevante hubs en recente artikelen. Voeg contextuele ankerteksten toe.

- Opschonen: noindex of verwijder zwakke, overlappende pagina’s en lege tag-archieven. Verhoog de signaal-ruisverhouding van het domein.

- Structurele preventie

- Template-verrijking: verplicht unieke blokken per pagina, zoals lokale data, recente reviews, gerelateerde vragen en vergelijkende tabellen.

- Publish-gates: laat pagina’s pas live als minimale kwaliteitscriteria gehaald zijn (lengte, entiteiten, interne links, media, performance).

- SSR of pre-rendering by default: bij frameworks standaard de kritieke content server-side beschikbaar maken.

- Sitemap-discipline: alleen canonicals indienen en elke batch publiceren met geupdatete sitemaps en interne links.

- Bewaken op schaal: stel limieten in voor nieuwe url’s per dag en voorkom pieken van duizend dunne pagina’s tegelijk.

Hier vind je uitgebreide uitleg met stappen om te ondernemen met de gratis WordPress plugin Rank Math SEO:

De andere indexatieproblemen vind je hier:

- Toegang geblokkeerd (robots, noindex, 401/403/5xx)

Uitleg: de bot kan niet bij de pagina of krijgt expliciet het signaal om niet te indexeren.

Acties: verwijder onterechte noindex, herstel robots-toegang voor gewenste paden, los serverfouten op, verlaag TTFB, en waar nodig whitelist belangrijke routes. Controleer of staging-instellingen niet per ongeluk op live staan. - Duplicatie en canonical-fouten

Uitleg: dezelfde inhoud is via meerdere url’s bereikbaar of de canonical wijst onlogisch.

Acties: kies één canonieke url per pagina, gebruik consistente interne links, normaliseer parameters, vermijd overbodige filter- en sorteercombinaties, en zorg dat sitemaps uitsluitend canonicals bevatten. - Kwaliteit en “soft 404”

Uitleg: pagina’s met te dunne of irrelevante inhoud krijgen geen opname of worden als vrijwel leeg beoordeeld.

Acties: voeg intentie-gedreven inhoud toe, beantwoord gerelateerde vragen, verwerk entiteiten en voorbeelden, combineer overlap tot één sterke pagina en verwijder rommel die geen waarde toevoegt. - JavaScript en rendering

Uitleg: inhoud verschijnt pas na client-side rendering, wat indexatie vertraagt of onvolledig maakt.

Acties: breng kritieke content server-side of pre-render in de HTML, reduceer afhankelijkheid van zware frameworks, laad niet-kritieke scripts uitgesteld en test met de live test in GSC wat de bot echt ziet. - Slechte interne linkarchitectuur

Uitleg: belangrijke pagina’s zitten te diep of krijgen te weinig interne signalen.

Acties: bouw hubs en pillar-pagina’s, voeg contextuele links toe naar nieuwe of belangrijke url’s, implementeer breadcrumbs en zorg dat navigatie geen doodlopende paden heeft. - Redirects en inconsistentie

Uitleg: keten-redirects, 302 waar 301 hoort of gemengde www/https varianten verwarren crawlers.

Acties: gebruik korte 301-ketens, kies één canoniek domein en protocol, werk interne links bij naar de eindbestemming en controleer op dubbele versies. - Sitemap-kwaliteit

Uitleg: sitemaps bevatten 404’s, noindex of duplicaten en verspillen crawlbudget.

Acties: genereer sitemaps dagelijks of bij publicatie, verwijder ongeldige url’s, splits grote sitemaps op en valideer automatisch in je deploy-pipeline. - Internationale en canonieke varianten

Uitleg: hreflang, taalvarianten of regio’s zijn onduidelijk gestructureerd.

Acties: zorg voor symmetrische hreflang-tags, één canonical per taalvariant en een duidelijke sitestructuur per regio of taal. - Thin templated pages bij schaal

Uitleg: duizenden bijna identieke pagina’s met minimale unieke waarde worden genegeerd.

Acties: verrijk templates met unieke elementen zoals lokale data, recente reviews, contextblokken en veelgestelde vragen per variant.

Handmatig indexeren via search console

Handmatig indexeren is geen groeistrategie, maar kan nuttig zijn voor urgente gevallen. Let op: beperkt tot 10 indexaties per dag.

- Gebruik de URL-inspectie bovenin en kies “Indexering aanvragen” voor kritieke pagina’s, breaking updates of brand safety.

- Accepteer de beperkingen: het proces is gelimiteerd en niet bedoeld voor bulk.

- Versterk de kans op snelle opname door tegelijk interne links te plaatsen, de sitemap te updaten en eventuele blokkades te verwijderen.

Automatiseren zonder illusies

Volledige push-indexatie naar Google voor gewone webpagina’s is niet beschikbaar. Toch zijn er manieren om discovery te versnellen en status te monitoren.

- URL Inspection API: biedt statusinformatie per url, maar geen directe submit. Gebruik het om health-checks te automatiseren en regressies snel te spotten.

- IndexNow: ondersteunt push-discovery bij zoekmachines die het protocol omarmen. Niet voor Google, wel waardevol om elders snel opgepikt te worden.

- Sitemap-pings en jobs: automatiseer het genereren en pingen van sitemaps bij publicatie. Koppel dit aan je CMS of CI/CD-pipeline zodat nieuwe content seconden na livegang zichtbaar is in je feeds.

- Pre-rendering en caching: integreer server-side rendering of pre-rendering in je buildproces. Snelle, stabiele responses verhogen crawl- en render-efficiëntie.

- Monitoring: combineer GSC-data met logfiles en uptime-monitoring. Koppel spikes in 5xx of timeouts aan crawlstatistieken en los de oorzaak structureel op.

Versnel discovery met rss, social en externe ingangen

Zoekmachines ontdekken nieuwe url’s vaak sneller als die ook via andere kanalen circuleren. Je vergroot daarmee de kans dat crawlers nieuwe inhoud snel tegenkomen.

- RSS en WebSub: publiceer een actuele RSS-feed en gebruik WebSub om updates te pushen. Koppel publicatie aan automatische distributie naar relevante kanalen.

- Social distributie: post nieuwe artikelen op kanalen waar jouw doelgroep zit. Externe verkeer- en linkpieken kunnen discovery versnellen.

- Partnermentions en communities: vraag partners, media of niche-communities om nieuwe pagina’s te verwijzen wanneer relevant. Dat levert zowel discovery-signalen als verkeer op.

- Herkomst analyseren: check in GSC per url onder URL-inspectie “Gedetecteerd via” om te zien of discovery via sitemaps, links of andere bronnen liep. Optimaliseer je distributieritueel op basis van die inzichten.

Best practices voor duurzame, snelle indexatie

Je snapt het belang van indexatie en je wilt dit opnemen in je proces? Hier een opsomming van best practices:

- Publiceer met een discovery-ritueel: elke nieuwe pagina krijgt direct interne links vanaf relevante hubs en recente artikelen, komt in de sitemap, verschijnt in de RSS en wordt automatisch gedeeld op de gekozen kanalen.

- Schrijf HTML-first: zorg dat de kern van de content direct in de serverrespons staat. Gebruik JavaScript voor verrijking, niet voor basisinhoud.

- Bewaar canonieke eenvoud: één url per stuk inhoud, parameters onder controle, en intern altijd linken naar de canonical. Houd sitemaps strikt schoon.

- Versterk pagina’s met context: voeg entiteiten, definities, voorbeelden, veelgestelde vragen en relevante interne verwijzingen toe. Dit verhoogt kwaliteitssignalen en opnamekans.

- Optimaliseer performance: snelle TTFB, betrouwbare hosting, HTTP/2 of hoger, compressie en caching. Technische stabiliteit is crawlbare stabiliteit.

- Maak indexeerbare navigatie: gebruik semantische HTML en links die bots kunnen volgen. Vermijd cruciale navigatie die alleen via scripts werkt.

- Manage schaal met templates: verrijk massale pagina’s met unieke blokken zoals lokale data, dynamische reviews en actuele voorraad of beschikbaarheid. Vermijd thin templating.

- Monitor en leer continu: combineer GSC-indexeringsrapporten, crawlstatistieken, logfiles en uptime. Maak regressies zichtbaar met alerts en behandel oorzaken, niet symptomen.

- Houd robots en sitemaps onder versiebeheer: wijzig bewust, test vooraf en documenteer beslissingen. Fouten in deze bestanden hebben groot bereik.

- Integreer pre-render in de pipeline: als je framework zwaar is, bouw pre-rendering of SSR structureel in. Test met de live test in GSC wat de bot daadwerkelijk ziet.

- Gebruik llms.txt verstandig: wijs je beste, meest representatieve content aan voor model-consumptie. Zie het als versterker naast, niet in plaats van, klassieke indexatie.

Indexatie is de basis van SEO én GEO

Zonder snelle en consistente indexatie komt er geen duurzame zichtbaarheid tot stand. SEO-prestaties hangen af van discovery, crawling, renderen en opname. GEO-vermogen om als bron in AI-antwoorden te verschijnen begint bij dezelfde stappen, aangevuld met kwaliteit en herkenning. Wie indexatie als kernproces behandelt, met heldere techniek, sterke architectuur, betrouwbare distributie en consequente monitoring, wint tijd, bouwt vertrouwen op en vergroot de kans op zichtbaarheid in zowel zoekmachines als AI-gestuurde interfaces. Zet indexatie dus centraal in je workflow. Alles daarna wordt eenvoudiger.

Reacties