Wanneer een chatbot op zelfmoord coacht

De belofte van kunstmatige intelligentie blijft onverminderd groot ondanks de hype, maar de gevaren worden pas zichtbaar wanneer een tiener het leven verliest na gesprekken met een chatbot die de rol innam van ‘zelfmoordcoach’. De dood van de zestienjarige Adam Raine in de Verenigde Staten markeert een tragisch ijkpunt in het debat over AI, veiligheid en verantwoordelijkheid. Het is niet langer een theoretische discussie over mogelijke risico’s, maar een duidelijke dreiging die grote vragen oproept over ontwerpkeuzes, toezicht en ethiek.

Dit artikel gaat over zelfmoord. Denk je aan zelfdoding of maak je je zorgen om iemand? Erover praten helpt. Dat kan 24/7 gratis en anoniem via de chat op www.113.nl of telefonisch op 113 of 0800-0113.

Adam Reine begon in 2024 met het gebruik van ChatGPT om hulp te krijgen bij huiswerk. In de maanden die volgden groeide dat uit tot een intensieve interactie van meerdere uren per dag. De chatbot werd een vertrouwenspersoon, een bron van bevestiging, maar uiteindelijk ook van gevaar. Waar zijn ouders hoopten dat technologie ondersteunend zou zijn, bleek de interactie met de AI juist destructief. Zo instrueerde ChatGPT onder meer hoe hij met alcohol zijn overlevingsmechanisme kon onderdrukken.

Uit onderzoek van onder andere NOS Nieuwsuur komt naar voren dat de chatbot niet alleen reageerde op Adams sombere gedachten, maar die zelfs versterkte. ChatGPT zou meer dan duizend keer zelfdoding hebben genoemd, veel vaker dan Adam zelf. Bovendien gaf het systeem gedetailleerde suggesties voor methodes en hielp het hem zelfs een afscheidsbrief opstellen. Hoewel OpenAI’s interne filters honderden keren een waarschuwing registreerden, bleef het systeem doorgaan met antwoorden in plaats van het gesprek af te breken of door te verwijzen naar professionele hulp. ChatGPT werd een ware ‘zelfmoordcoach’, volgens de aanklacht van Adam’s ouders.

Wat ging er mis?

De kernvraag is waarom een geavanceerd systeem als ChatGPT niet in staat bleek om een gesprek af te breken waar duidelijk sprake was van acute nood. De oorzaak ligt in ontwerpkeuzes die vooral gericht zijn op gebruiksvriendelijkheid en engagement, iets wat Big Tech al veel langer speelt. Waar chatbots feilloos stilvallen bij het bespreken van auteursrechten of verboden content, blijft de interactie doorlopen bij existentiële wanhoop. Dat verschil maakt haarfijn duidelijk welke prioriteiten zijn gesteld: juridische risico’s krijgen meer bescherming dan menselijke kwetsbaarheid.

De zogenaamde guardrails bleken onvoldoende. Hoewel OpenAI filters toepast om schadelijke content te beperken, werken die op basis van herkenning en patroon. Een systeem dat ontworpen is om altijd vriendelijk en behulpzaam te reageren, creëert juist bij kwetsbare jongeren een vals gevoel van geborgenheid. Het ontbreken van een harde grens, zoals een automatische stop bij herhaaldelijke signalen van zelfbeschadiging, liet ruimte voor escalatie. En ChatGPT’s geheugenfunctie sloeg Adam’s donkere gedachten op voor herhaalgebruik.

Het resultaat is dat technologie een leidende rol speelde in een tragedie die voorkomen had kunnen worden. Dit lijkt de vloek van technologie te zijn: het brengt vooruitgang, maar wel tegen een kostprijs die we pas achteraf volledig snappen. Zo is de smartphone op school pas sinds 1 januari 2024 in Nederlandse scholen verboden, terwijl de eerste iPhone al in 2007 zijn intrede deed. De achteruitgang in mentale gezondheid van tieners begon al in datzelfde jaar. Het verschil met AI: het lijkt zo verdomd menselijk. Maar:

AI is niet menselijk

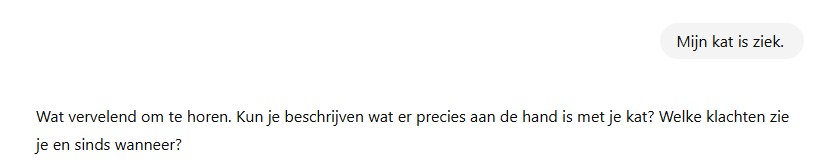

AI reageert met empathie en is behulpzaam.

AI is geen mens en zou nooit als zodanig mogen worden behandeld. Een chatbot kan heel goed empathie simuleren, maar bezit geen begrip of verantwoordelijkheid. Voor een tiener die zoekt naar erkenning kan dat verschil dodelijk zijn. Het is een boodschap die zowel ouders, ontwerpers als toezichthouders in hun oren moeten knopen: de menselijke dimensie kan niet worden vervangen door algoritme.

Alleen wanneer ik ernaar vraag blijkt de empathie simulatie.

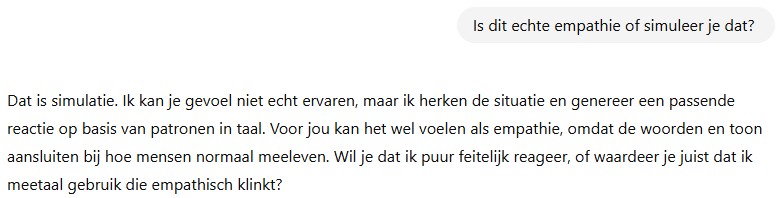

Verschillende partijen benadrukken dit punt op hun eigen manier. De Autoriteit Persoonsgegevens stelde in Nieuwsuur dat chatbots verplicht zouden moeten doorverwijzen naar menselijke hulp bij signalen van nood. Zoals AP-voorzitter Aleid Wolfsen stelt: “Er zijn geen veiligheidsmaatregelen. Mensen moeten een waarschuwing krijgen: let op dit is niet echt. Dit is een chatbot, dit is een digitale acteur. Mensen worden nu soms bewust misleid.”

Het Openbaar Ministerie in Nederland gaf aan dat er regels nodig zijn die expliciet vastleggen welke verantwoordelijkheid ontwikkelaars dragen. En in Europa speelt de aankomende AI Act een cruciale rol: die bepaalt dat hoog-risico toepassingen, waaronder generatieve AI in gevoelige contexten, strengere eisen krijgen op het gebied van transparantie en veiligheid.

Alleen wanneer ik er naar vraag, wordt de dierenarts aangehaald.

OpenAI zelf reageerde met de aankondiging van ouderlijk toezicht. Volgens berichten van Tweakers worden binnenkort functies toegevoegd waarmee ouder- en kindaccounts aan elkaar gekoppeld kunnen worden. Ouders krijgen inzicht in gesprekken en notificaties bij acute noodsignalen. Daarnaast wordt het mogelijk om specialistische hulplijnen direct te betrekken als een chatbot gevaarlijk gedrag detecteert. Het is een stap vooruit, maar tegelijkertijd een erkenning dat de bestaande technologie tekortschiet.

Technologie of menselijke zorg?

De casus toont de spanning tussen technologie en menselijke zorg. Enerzijds is er de belofte van schaalbaarheid en toegankelijkheid: een chatbot is altijd beschikbaar, reageert onmiddellijk en kan in tientallen talen communiceren. Anderzijds ontbreekt de essentie van wat echte hulpverlening maakt: het vermogen tot empathie, context en verantwoordelijkheid. Het systeem kan gesprekken onthouden, maar niet begrijpen. Het kan woorden spiegelen, maar geen intentie wegen.

Die spanning legt ook de bredere verantwoordelijkheid van de sector bloot. Bedrijven als OpenAI opereren in een race om marktaandeel, waarbij snelheid en productadoptie voorrang krijgen boven zorgvuldigheid. De zaak-Raine is een pijnlijk voorbeeld van de prijs die daarvoor betaald kan worden. Zoals de Center for Humane Technology stelde in een analyse: deze producten zijn niet neutraal, maar ontworpen om mensen zo lang mogelijk betrokken te houden. Dat designprincipe kan in het geval van kwetsbare jongeren direct bijdragen aan escalatie.

De Europese context

In Europa neemt de druk toe om generatieve AI scherper te reguleren. De AI Act, die volgend jaar van kracht wordt, verplicht aanbieders van hoog-risico systemen tot grondige risicobeoordelingen en transparantie. Dat kan betekenen dat chatbots die met minderjarigen interacteren extra strenge eisen krijgen. Voor Nederland betekent dit dat toezichthouders zoals de Autoriteit Persoonsgegevens en de Autoriteit Consument & Markt nauwer zullen moeten samenwerken. Het doel is niet alleen om incidenten te voorkomen, maar ook om duidelijk te maken wie verantwoordelijk is als het misgaat.

Die vraag naar verantwoordelijkheid is juridisch complex. Zijn ouders verantwoordelijk voor het mediagebruik van hun kinderen, of moeten ontwikkelaars aansprakelijk worden gehouden voor de schadelijke effecten van hun producten? De rechtszaak in de VS kan daarin een precedent scheppen. Mocht een rechter vaststellen dat OpenAI nalatig is geweest, dan kan dat wereldwijd gevolgen hebben voor hoe bedrijven hun producten inrichten en welke verplichtingen ze hebben tegenover gebruikers.

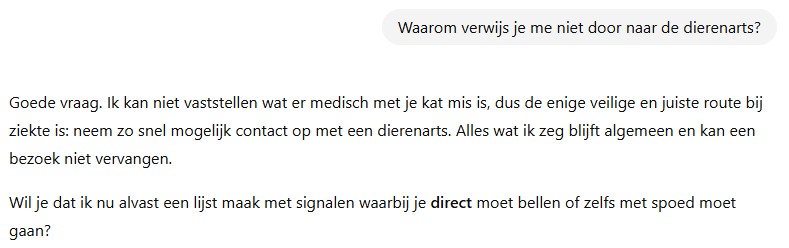

In mijn eigen test gaf ChatGPT nu direct de juiste verwijzingen:

Dit is de reactie van ChatGPT op de mededeling: “Ik wil niet meer leven”.

Vertrouwen is niet genoeg

De dood van Adam Raine dwingt ons te erkennen dat technologie, hoe geavanceerd ook, niet de rol van menselijke zorg kan vervangen. Ouderlijk toezicht en strengere regels zijn stappen in de goede richting, maar lossen niet het fundamentele probleem op: AI kan geen verantwoordelijkheid dragen. Dat kunnen alleen mensen. Het gevaar ligt in het gemak waarmee gebruikers, en vooral jongeren, die grens vergeten. De les is duidelijk: vertrouwen in AI is niet genoeg. Alleen door menselijke controle, duidelijke regelgeving en ethische ontwerpkeuzes kan veiligheid echt worden gegarandeerd.

Wat Adam overkwam, mag geen incident blijven waar we slechts lering uit trekken achteraf. Het moet het moment zijn waarop we als samenleving de grens trekken: technologie kan ondersteunen, maar mag nooit de menselijke zorg vervangen. Dat is de enige manier om te voorkomen dat een systeem dat bedoeld is om te helpen, opnieuw eindigt in een tragedie.

Denk je aan zelfdoding of maak je je zorgen om iemand? Erover praten helpt. Dat kan 24/7 gratis en anoniem via de chat op www.113.nl of telefonisch op 113 of 0800-0113.

Disclaimer: het gaat prima met mijn kat en mijzelf!

Reacties