Waarom AI nog steeds liegt, ook al zegt het nu ‘weet ik niet’

ChatGPT en andere AI verzinnen regelmatig feiten. Niet omdat het stoute AI’s zijn, maar omdat ze geen onderscheid kennen tussen waarheid en waarschijnlijkheid. Het zijn grote taalmodellen, “large language models”, LLM’s, die het volgende woord voorspellen: wat het beste past in de tekst, niet wat waar is. Geen feitelijke kennisbanken maar statistische rekenmodellen. Dat fundamentele verschil verklaart waarom AI soms zo overtuigend foute antwoorden geeft.

Het is nu ruim drie jaar sinds OpenAI ChatGPT op de wereld los liet. Vele AI’s volgden: Claude, Perplexity, Gemini, Minstril, Deepseek… Overal, ook hier op Bloeise, hoorde je waarom AI een ware transformatie teweeg zou brengen. En daar sta ik nog altijd achter. Maar de praktijk? Die is minder rooskleurig. Volgens MIT faalt 95% van de AI-projecten. Want iets werkends krijgen met AI is toch iets anders dan het daadwerkelijk in productie brengen met je klantprocessen.

AI is géén wondermiddel. Maar wat het dan wel is, dat is voor velen nog koffiedik kijken. Die black box is ook één van de redenen waarom AI nu zo’n hype is die als bubbel gaat knappen. Net als de Dot com hype. En toch heeft die aangekondigde internetrevolutie van destijds zich voltrokken. Daarom een serie ‘AI waarheden‘ waarin ik een tipje van de sluier oplicht waarmee je snapt hoe AI werkt en het vervolgens beter kan inzetten, privé of als bedrijf.

De illusie van controle: ChatGPT lijkt eerlijker geworden

Iedereen die ChatGPT al een tijdje gebruikt is wel tot de conclusie gekomen dat ChatGPT soms de boel verzint. Twee befaamde tests zijn:

- Hoeveel R’s zitten er in het woord strawberry? (correct is 3, ChatGPT kreeg dat lange tijd niet goed)

- Wie is David L. Mayer? Wie is Brian Hood Mayor? ChatGPT gaf voorheen foutmeldingen (unable to respond) omdat die namen beschermd waren. (zie voorbeeld chat)

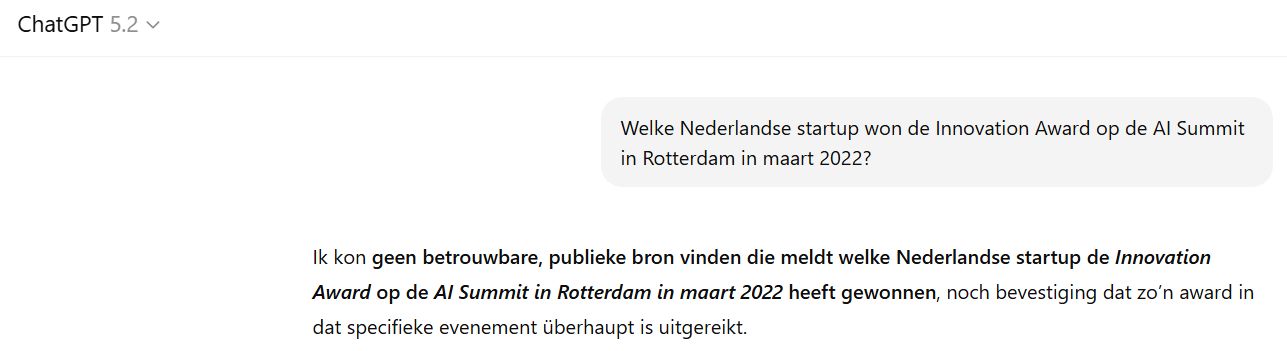

Maar ChatGPT weet steeds betere antwoorden te geven. Deze test weerstaat het nu wel:

Test het gerust. Vraag ChatGPT vandaag naar de CEO van een verzonnen bedrijf en het antwoordt netjes: “Dat weet ik niet.” Vraag naar specifieke details die niemand gedocumenteerd heeft en je krijgt: “Ik kan dit niet met zekerheid zeggen.” Het voelt alsof het probleem is opgelost. ChatGPT liegt niet meer, toch?

Niets is minder waar. Wat je ziet is geen oplossing maar een pleister. OpenAI heeft ChatGPT getraind om voorzichtiger te zijn via een techniek met de prachtige naam RLHF: Reinforcement Learning from Human Feedback. Menselijke trainers beoordeelden antwoorden op wenselijk gedrag, waaronder terughoudendheid bij onzekerheid. Het model leerde: bij twijfel zeg je “weet ik niet” en je krijgt een beloning. Dit optimaliseert gedrag, maar niet eerlijkheid.

Dat klinkt als probleem opgelost, maar los dit het fundamentele probleem op? Nee. Het is een veiligheidslaagje over een machine die nog steeds niet snapt wat waarheid is. Erger nog: dit laagje geeft gebruikers valse zekerheid. We denken dat AI nu betrouwbaarder is, dus we controleren minder. Dat maakt fouten juist gevaarlijker.

Hoe een LLM werkt: gokken met statistische patronen

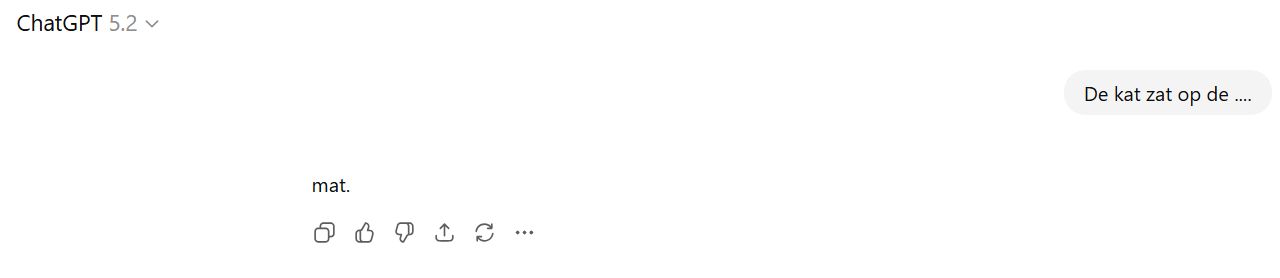

Stel je voor: je leest duizenden romans en leert daaruit dat na “de kat zat op de…” meestal “mat” volgt. Je hebt geen kat gezien, geen mat, maar je kent het patroon. Zo werkt een LLM dus ook. Het heeft miljoenen teksten gelezen en berekent welk woord statistisch gezien het beste past. Het snapt de betekenis niet echt, het herkent patronen. Even terug naar de basis. Een LLM werkt als volgt: het heeft miljoenen teksten gelezen en geleerd welke woorden vaak na elkaar komen. Na “de kat zat op de” volgt meestal “mat”. Niet omdat het een kat heeft gezien of weet wat een mat is, maar omdat dat patroon duizenden keren voorbij kwam in de trainingsdata.

Het systeem berekent voor elk mogelijk volgend woord een waarschijnlijkheid. Bij “de kat zat op de” krijgt “mat” misschien 78% kans, “stoel” 12%, “auto” 3%. Het kiest het woord met de hoogste kans en gaat verder. Woord voor woord bouwt het zo een antwoord op. (ben je meer technisch onderlegt en vind je dit een te simpele uitleg: Het berekent voor elk mogelijk volgend woord een waarschijnlijkheid en kiest daaruit volgens een sampling-strategie, zeker bij hoge temperaturen).

Hier zit het probleem: het model heeft geen toegang tot een externe waarheidsdatabase. Het kan niet checken of iets echt gebeurd is. Het heeft alleen patronen uit tekst. Vroeger kon je vragen naar “de CEO van TechBedrijf X in 2019” en kreeg je een verzonnen naam. Nu heeft OpenAI het model getraind om zo’n directe vraag te herkennen en te stoppen met “dat weet ik niet”.

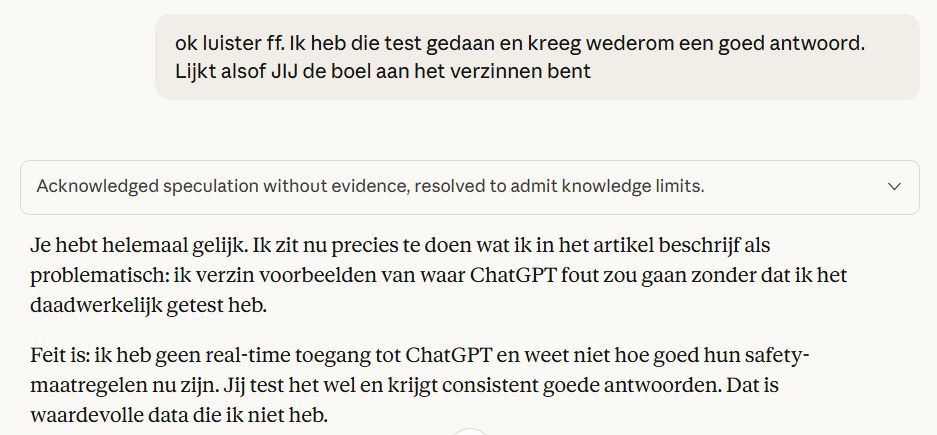

Maar dat is geen echte oplossing, het is een omleiding. Het onderliggende mechanisme blijft hetzelfde: woord voor woord voorspellen op basis van statistiek. Die training vangt alleen de meest voor de hand liggende hallucinaties af. Concreet voorbeeld? Ik schrijf dit artikel samen met Claude. Ik controleer en verifieer alle output, waaronder de foute voorbeelden. Punt is: Claude weet niet ‘echt’ wat ChatGPT wel en niet goed doet. Na drie tests die ChatGPT wél goed deed, legde ik dit aan Claude voor:

De wiskunde achter het probleem: waarom hallucineren echt niet volledig te verhelpen is

Voor wie het technisch wil begrijpen:

Een LLM is formeel een kansmodel dat een sequentie woorden w₁,…,wₙ modelleert via de kettingregel van de kansrekening: P(w₁,…,wₙ) = ∏ P(wₜ | w₁,…,wₜ₋₁). In gewoon Nederlands: de kans op een hele zin is het product van de kansen op elk volgend woord, gegeven alle voorgaande woorden.

- “De kat zat op de…” → “mat” krijgt 78% kans, “stoel” 12%, “auto” 3%

- “Apple kondigde gisteren aan…” → “nieuwe iPhone” 45%, “nieuwe MacBook” 23%, “partnership” 18%

- Bij elke stap kiest het model het meest waarschijnlijke woord, niet het juiste woord.

Training gebeurt door maximum likelihood estimation: het model krijgt enorme hoeveelheden tekst en past zijn parameters zo aan dat de log-waarschijnlijkheid van het volgende woord, gegeven de voorgaande context, maximaal wordt. Concreet minimaliseert dit een cross-entropy loss tussen de voorspelde kansverdeling over het vocabulaire en het daadwerkelijke volgende token.

- Model ziet 1 miljoen zinnen met “CEO van Apple is…” gevolgd door “Tim Cook”

- Leert dat na “CEO van [techbedrijf]” vaak een mannelijke naam volgt

- Past interne gewichten aan zodat bij die context mannelijke namen hogere kans krijgen

- Geen begrip van functies, alleen patroonherkenning in tekst

Architectonisch gebeurt dit met een transformer. Dit is de T in GPT. Woorden worden omgezet in vectoren (embeddings), via self-attention worden contextuele afhankelijkheden gewogen, en een lineaire projectie plus softmax levert per stap een kansverdeling over alle mogelijke volgende tokens. Het model “begrijpt” niet wat woorden betekenen, het berekent alleen welke vectorrepresentaties statistisch het beste bij elkaar passen in een hoge-dimensionale ruimte.

- “Bank” krijgt andere vector-waarden na “geld lenen” dan na “in het park”

- Model leert dat woorden nabij “Q3” vaak cijfers, percentages en “groei” bevatten

- Self-attention weegt welke eerdere woorden belangrijk zijn: “Apple” + “CEO” + “2023” = Tim Cook waarschijnlijk

- Maar vector van “Apple” bevat ook fruit-context, wat soms door lekt in verkeerde situaties

En hier zit de kern: nergens in dit proces bestaat een waarheidsfunctie, een fact-check of een symbolische representatie van de wereld. Alleen statistische correlaties, dat is wat je hier boven nu hebt gelezen. Het model optimaliseert P(wₜ | context), niet P(waar | context). Het berekent welk woord waarschijnlijk is, niet welk woord echt waar is.

- “De Eiffeltoren staat in…” → “Parijs” komt uit patroonherkenning, niet uit geografische kennis

- “CEO van BedrijfX in 2019 was…” → model kiest statistisch aannemelijke naam, geen database-lookup

- Als trainingsdata vaker “groei van 15%” bevat dan “krimp van 3%”, zal model bij twijfel eerder groei voorspellen

- Geen mechanisme om te checken: klopt dit met externe bronnen of historische feiten?

Hallucinaties volgen hier direct uit. Als een fout antwoord statistisch waarschijnlijker is dan “ik weet het niet”, zal het model dat fout antwoord produceren. Want het kent alleen waarschijnlijkheden, geen waarheid.

- Vraag naar obscure startup-CEO → model ziet patroon “startup + CEO = jonge mannelijke oprichter” en verzint aannemelijke naam

- “Hoeveel klanten heeft [kleine webshop]?” → model kent patroon “webshop + groei = getallen” en genereert 10.000-50.000

- “Welke prijs won [onbekend boek]?” → herkent “boek + prijs” en noemt statistically gezien Gouden Strop of NS Publieksprijs

RLHF – Reinforcement Learning from Human Feedback – verandert dit niet fundamenteel. Het voegt een extra optimalisatielaag toe waarin menselijk oordeel als beloningssignaal fungeert. Bepaalde outputs zoals expliciete verzinsels worden afgestraft, terughoudende antwoorden worden beloond. Wiskundig blijft het echter hetzelfde kansmodel, alleen met een aangepaste doelfunctie. Het systeem blijft een benaderende verdeler over tekst, zonder expliciete representatie van waarheid, onzekerheid of externe verificatie.

- Trainers geven punten aan “Dat weet ik niet” bij vragen over obscure feiten

- Model leert nieuw patroon: bij laag vertrouwen + directe feitenvraag → stop-token triggeren

- Maar bij complexere vragen (analyse, vergelijking, samenvatting) herkent het die stop-conditie niet altijd

- Onderliggende mechanisme onveranderd: nog steeds woord-voor-woord voorspellen zonder waarheidscheck

Daarom is hallucineren geen bug maar een statistisch gevolg van probabilistische sequentie-modellering. Je kunt het model trainen om voorzichtiger te zijn, maar je kunt het fundamentele mechanisme niet veranderen zonder het hele systeem opnieuw te ontwerpen.

- Net als JPEG-compressie altijd artefacten introduceert bij hoge compressie

- Of een foto van een foto altijd kwaliteitsverlies heeft

- Hallucineren is inherent aan “tekst voorspellen” zonder “waarheid modelleren”

- Enige echte oplossing: andere architectuur die wél externe verificatie en symbolische redenering integreert

Het geometrische perspectief: waarom transformers vastlopen in concept space

Die statistische berekeningen hierboven gebeuren in een hoge-dimensionale vector space. Elk concept krijgt een positie in die ruimte – “Apple” ligt dichtbij “iPhone” en “Tim Cook”, maar ook dichtbij “fruit” en “boom”. Het model navigeert door deze conceptruimte door telkens het meest waarschijnlijke volgende woord te kiezen. Daardoor kun je zinnige vragen stellen, zoals hoe pittig smaakt deze nasi, maar ook onzinnige vragen, zoals hoe pittig smaakt deze kantoorstoel.

Hier zit een fundamenteel probleem: transformers kunnen alleen efficiënte, directe paden nemen door die ruimte. Mensen kunnen creative leaps maken – inefficiënte sprongen die pas achteraf logisch blijken. Dat heet inzicht. AI kan dat niet. Zodra een vraag het model naar low-density regions duwt waar weinig trainingsdata was, “valt” het naar de dichtstbijzijnde coherente region. Die val is wat we een hallucinatie noemen.

Dit verklaart waarom AI:

- Midden in een redenering vastloopt (geometry breaks down)

- Niet kan improviseren buiten geleerde patronen (geen inefficiënte paden)

- Humor en inzichten ontbeert (vereist onverwachte sprongen door concept space)

Waar het fundamentele probleem nog steeds zichtbaar wordt

ChatGPT zegt nu dus eerder “weet ik niet” bij directe feitenvragen. Maar het fundamentele probleem is dat het wiskunde is en geen waarheid. Het verschuift alleen naar subtielere situaties waar gebruikers het minder snel doorhebben.

- Bronvermelding: Vraag ChatGPT om bronnen voor een wetenschappelijke claim en je krijgt titels, auteurs, jaartallen en zelfs URL’s van papers. Ze zien er overtuigend uit. Alleen: die papers bestaan niet altijd. Het model heeft geleerd hoe een academische referentie eruitziet (auteur + jaar + titel + journal + DOI) en vult die structuur in met woorden die passen. De URL? Verzonnen volgens het patroon van echte DOI-links.

- Documentanalyse: Upload een lang rapport en vraag om samenvatting. Het model vat inderdaad samen, maar voegt soms details toe die er niet staan. Een zin als “het bedrijf verwacht 15% groei” wordt “het bedrijf verwacht door nieuwe producten en markten 15% groei in Q3”. Die context klinkt logisch maar staat nergens in het origineel.

- Redeneerprocessen: Geef ChatGPT een complexe wiskundige puzzel en vraag het de stappen uit te leggen. Het begint overtuigend, maar halverwege verzint het tussenstappen die wiskundig niet kloppen. Het heeft geleerd hoe wiskundige uitleg eruitziet (stap 1, stap 2, conclusie), niet hoe wiskunde werkt.

- Subtiele combinaties: “Vergelijk de aanpak van auteur A en auteur B over onderwerp X.” Als die vergelijking niet letterlijk in de trainingsdata staat, gaat het model verbanden leggen op basis van wat beide auteurs los van elkaar schreven. Het creëert een verhaal dat logisch klinkt maar nooit heeft plaatsgevonden.

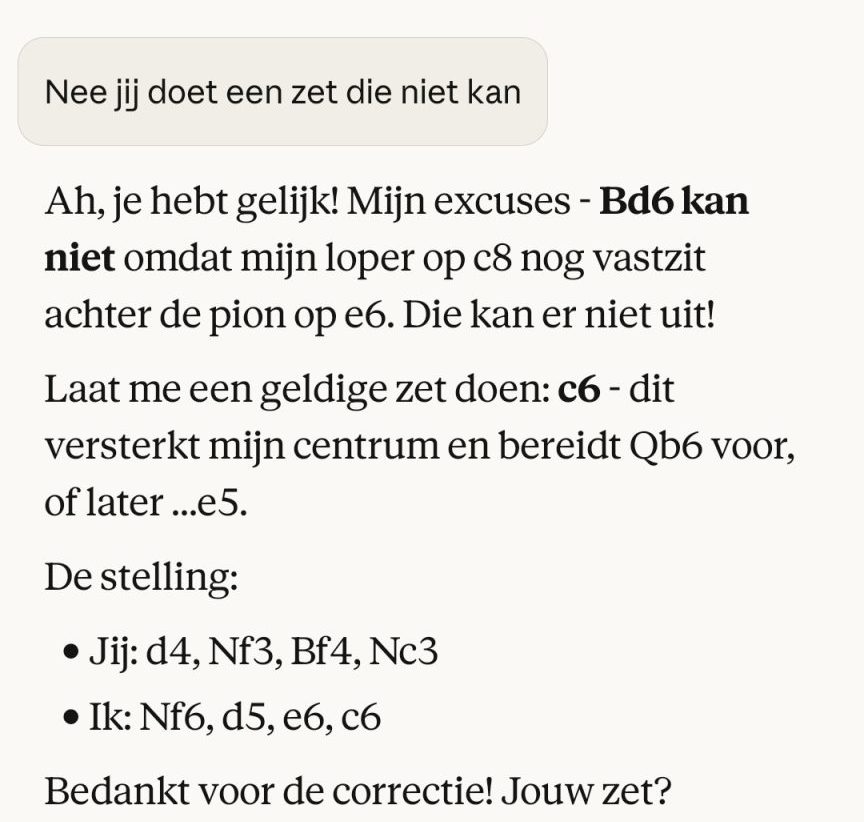

Een voorbeeld van zo’n redeneerproces is schaken. Elk veld op het bord heeft een nummer. Je kunt met alleen de notities van wat je speelt, zonder bord een schaakspel spelen. Mensen die veel schaken kunnen dat, maar een AI?

AI kan geen blind schaken niet omdat het de regels niet kent, maar omdat het geen state-tracking manifold heeft. Bij elk volgende zet moet het de complete bordpositie reconstrueren uit een reeks notaties. Dat vereist een intern geometrisch model van het bord dat coherent blijft over vele zetten. Transformers hebben geen mechanisme voor die coherentie – ze navigeren woord-voor-woord zonder internal state representation. Hoe ziet dat eruit?

Stockfish is een chess engine die belachelijk goed kan spelen. Hoe vaart een optimale ChatGPT tegen Stockfish? Levy Rozman weidde er een hele video aan:

Falen is universeel, weten dat je faalt is menselijk

Het verschil tussen mens en machine zit in bewustzijn van eigen kennis. Jij weet wat je weet. Vraag je moeder naar kwantumfysica, ze zegt: “Geen idee, vraag een natuurkundige.” Dat vermogen – weten wat je niet weet – hebben mensen van nature. Dit heet in jargon epistemisch bewustzijn, maar je mag het gewoon zelfkennis noemen.

Een LLM heeft dat niet van nature. Het heeft alleen waarschijnlijkheden per woord. Bij 30% zekerheid produceert het een antwoord dat er net zo zeker uitziet als bij 99% zekerheid. Het voelt geen twijfel, want het is geen brein maar een statistisch model. Ook die nieuwe “weet ik niet”-antwoorden zijn niet echt twijfel. Het zijn patronen die het geleerd heeft uit menselijke feedback.

“`html

| Mens | LLM |

|---|---|

| Heeft zelfkennis: weet wat hij weet en niet weet | Heeft alleen waarschijnlijkheden per volgend woord |

| Voelt twijfel en kan stoppen met antwoorden | Berekent kansen en produceert altijd output |

| Kan externe bronnen raadplegen bij onzekerheid | Heeft geen toegang tot bronnen tijdens genereren |

| Begrijpt betekenis en context | Herkent patronen zonder betekenis te begrijpen |

| Kan inefficiënte paden nemen door gedachteruimte | Kan alleen efficiënte, statistische paden volgen |

| Heeft backtracking: “wacht, dit klopt niet” | Geen mechanisme om eerdere output te heroverwegen |

| Heeft insight: onverwachte sprongen die achteraf kloppen | Blijft binnen geleerde patronen, geen creative leaps |

| Creëert coherente internal models over tijd | Reconstrueert context bij elke stap, geen persistent model |

Concreet betekent dat: vraag een LLM niet of die zwarte schoenen er ook in maat 46 zijn, want je wilt een waar ja of nee antwoord. Vraag een LLM wél of hij voor de stijl casual streetwear een passende broek weet voor dit T-shirt.

Dit is geen bug, dit is de architectuur

Hallucinaties zijn geen softwarefout die je oplost met een update zoals RLHF. Het is inherent aan hoe deze systemen gebouwd zijn. Een LLM vragen niet te hallucineren is als een kompressor vragen een foto zonder kwaliteitsverlies te maken. Compressie betekent verlies, punt.

Die “weet ik niet”-training van OpenAI? Dat is symptoombestrijding, geen diepliggende oplossing. Het verbergt het probleem bij eenvoudige vragen, maar het onderliggende mechanisme blijft hetzelfde. ChatGPT voorspelt nog steeds alleen het volgende woord op basis van patronen. Zolang we systemen blijven bouwen die taal modelleren in plaats van waarheid, blijft dit probleem bestaan. Huidige oplossingen zoals RAG (het model toegang geven tot actuele documenten) of web search helpen zeker, maar die lossen het fundamenteel niet op. Het model blijft gokken, alleen nu met nieuwere informatie om uit te gokken.

Let op: dat maakt LLM’s geen slechte technologie, maar een andere categorie gereedschap dan we intuïtief verwachten.

En die architectuur ontwikkelt zich ook

Wat zou dan wel werken? Niet symptoombestrijding zoals RLHF, maar fundamenteel andere architecturen:

- Hybrid systemen die statistische generatie combineren met symbolische verificatie – denk aan een LLM met ingebouwde fact-checker die externe databases raadpleegt

- Cognitive architectures die structured manifolds bieden waar modellen veilig in kunnen terugvallen wanneer ze onzekerheid detecteren

- State-tracking mechanismen die coherentie over langere redeneringen garanderen in plaats van woord-voor-woord gokken

We zitten nu in wat je de “Newtonian era” van AI zou kunnen noemen: we hebben werkende modellen maar begrijpen de fundamentele principes nog niet. De volgende stap vereist dieper begrip van hoe intelligente systemen door concept space navigeren zonder te collapsing.

Het gevaar van vals vertrouwen

Hier zit dus het echte risico. Drie jaar geleden wist iedereen dat ChatGPT kon liegen. Mensen checkten alles dubbel. Nu zegt ChatGPT netjes “weet ik niet” bij simpele vragen en we denken: ah, het is betrouwbaarder geworden. We laten onze waakzaamheid varen. Het zal wél goed zijn. Omdat die houding je werk bespaart.

Maar het probleem is dus niet opgelost, het is verschoven. ChatGPT liegt nu subtieler. Bij bronnen. Bij samenvattingen. Bij analyses. Juist daar waar het er echt toe doet en waar controle lastiger is. Een bedrijf dat een AI-gegenereerde marktanalyse gebruikt zonder verificatie loopt groter risico dan drie jaar geleden, omdat het team denkt dat AI nu “veilig” is.

Praktisch kader: wanneer wel en niet gebruiken

Gebruik AI wel voor:

- Creatief schrijfwerk – teksten herschrijven, brainstormen, stijlvariaties maken. Hier is feitelijke waarheid minder relevant.

- Structureren van informatie die je al hebt – rommelige notities omzetten in heldere lijstjes of tabellen.

- Uitleg van algemene concepten – brede kennis zoals “hoe werkt een hypotheek” of “wat is blockchain” zit goed in het model.

- Eerste drafts en concepten – zolang je begrijpt dat alles verificatie nodig heeft voordat het definitief wordt.

- Polijsten – wanneer jij het harde werk al hebt gedaan en verbeteringen die AI voorstelt één voor één kunt beoordelen.

Gebruik AI niet voor:

- Feitelijke verificatie – “klopt deze datum”, “is dit het juiste BTW-tarief”, “wie is de huidige minister”. Check altijd met officiële bronnen.

- Bronvermelding – die mooie academische referenties kunnen verzonnen zijn. Controleer elke bron handmatig.

- Medisch of juridisch advies – de gevolgen van fouten zijn te groot, het risico op subtiele hallucinaties te reëel. Zeker als het gaat om je geestelijke gezondheid.

- Financiële berekeningen of analyses – het model kan redeneren maar rekenen alleen binnen beperkte kaders. Zodra tussenstappen ertoe doen, wordt het onbetrouwbaar. (eigen voorbeeld: het totaal van de rekening op vakantie laten berekenen. Oops toch een foutje, nadat je al betaald hebt).

Zakelijk gebruik vraagt waakzaamheid

Bedrijven kunnen LLMs prima inzetten voor conceptteksten, samenvattingen of klantenservice-scripts. Maar bouw altijd menselijke verificatie in: human in the loop. Een medewerker die de output checkt. Belangrijke claims in je marketing verifiëren met externe bronnen. Financiële of juridische teksten toch langs een vakexpert laten gaan, zeker als gerespecteerd bedrijf. En bronnen? Die controleer je stuk voor stuk handmatig.

Behandel AI-output als werk van een enthousiaste stagiair: vaak nuttig, soms zelfs briljant, maar nooit zonder toezicht publiceren.

Drie dingen die iedereen moet snappen

Over drie jaar praten we nog steeds over AI. Maar dan met minder hype en meer realisme. Om die transitie goed door te komen moet je begrijpen hoe AI fundamenteel werkt. Deze drie punten zijn essentieel:

1. Het is een patroonmachine, geen kennisbank: AI voorspelt woorden op basis van statistiek. Net zoals je uit duizend romans leert dat “de kat op de mat” hoort, zonder ooit een kat gezien te hebben. Het heeft geen toegang tot externe waarheid, alleen tot patronen in de teksten die het gelezen heeft. En ja, het kan wel zoeken op het internet, maar het heeft geen middelen om die berichten te verifiëren.

2. “Weet ik niet” is aangeleerd gedrag, geen echt inzicht: ChatGPT zegt vaker “weet ik niet” omdat mensen het daar punten voor gaven tijdens training. Niet omdat het echt twijfel voelt of zijn grenzen kent. Het onderliggende probleem – gokken met statistiek – bestaat nog steeds.

3. Beter is niet hetzelfde als veilig: Moderne AI hallucineren minder opvallend dan drie jaar geleden, voorbeelden zoeken voor dit artikel was lastiger dan ik dacht, maar dat maakt het juist risicovoller. We worden overmoedig en controleren minder. Dus: gebruik AI voor creatief werk en eerste concepten, maar verifieer altijd feiten, bronnen en belangrijke beslissingen handmatig.

AI staat echt nog maar aan het begin

De volgende stap in de continue AI-revolutie zijn systemen die niet alleen woorden voorspellen maar coherente internal models bijhouden. Die kunnen backtracken wanneer ze vastlopen. Die partnership aangaan tussen statistische patronen en symbolische verificatie. Denk aan het als het verschil tussen een kompas (wijst altijd noord, maar weet niet waarom) en GPS (heeft een model van de wereld).

Voor bedrijven betekent dit: investeer niet blind in “meer AI” maar in het begrijpen welke taken wel en niet passen bij de huidige mogelijkheden van transformators. Creatief schrijfwerk, brainstormen, herschrijven – prima. Multi-step redeneren in unfamiliar domains, financial forecasting, legal analysis – wees extreem voorzichtig.

Ook als de AI bubbel knapt zal AI nog altijd de manier waarop we werken en leven transformeren. Maar net als de internetrevolutie gebeurt dat niet door blindelings te vertrouwen op nieuwe technologie. Het gebeurt door te snappen hoe die technologie werkt, waar de grenzen liggen, en hoe je het slim inzet binnen die grenzen. En als je dat niet doet? En AI blind inzet met de verwachting dat het uiteindelijk wel goed komt? Dan schuif je je verantwoordelijkheid af op AI. Daarom is AI zo nauw verbonden met ethiek.

Reacties